KI Songgeneratoren: Wenn Schrift zu Klang wird

In 30 Sekunden

- Das Problem: Musikproduktion brauchte bisher teure Instrumente, jahrelange Übung und ein Studio-Budget.

- Die Lösung: Plattformen wie Suno und Udio wandeln Text direkt in fertige Songs mit Gesang und Instrumenten um.

- Die Technik: Nutze Metatags wie [Chorus] oder [Bridge], um den Aufbau und die Emotionen des Songs zu steuern.

- Das Ziel: Werde vom Handwerker zum Dirigenten – du gestaltest den Klang, die KI übernimmt das Einspielen.

Wenn Schrift zu Klang wird: Dein Einstieg in die Ära der algorithmischen Komposition

Früher fixierte die Feder mühsam Melodien auf Papier. Wer Musik erschaffen wollte, musste die Grammatik der Notenblätter beherrschen und Jahre in die Ausbildung investieren. Heute weicht die Notenschrift dem Prompt. Du diktierst eine Stimmung, und Algorithmen übersetzen deine Semantik in präzise Frequenzen.

Dieser Wandel markiert den nächsten logischen Schritt innerhalb der SuBiB-Philosophie: Nachdem wir gelernt haben, wie Schrift und Bilder laufen lernen, liefert die generative Musik nun das rhythmische Rückgrat für dieses audiovisuelle Gesamtkunstwerk. Der Klang vervollständigt die „Schrift in Bewegung“. Er macht aus einer flüchtigen Sequenz ein Erlebnis, das Resonanz erzeugt.

Damit fällt eine der letzten großen Barrieren der kreativen Produktion. Die Distanz zwischen deiner Intuition und einem fertigen Arrangement schrumpft auf ein Minimum. Musik wird demokratisch. Du agierst nicht mehr als Bittsteller vor den Toren teurer Studios, sondern als Dirigent deines eigenen digitalen Orchesters. Die Barriere zwischen Idee und fertigem Song löst sich auf.

Das Studio von gestern passt heute in eine einzige Zeile Text.

Hinter den Wellenformen: So lernt die KI das Denken in Harmonien und Rhythmen

Der Weg von deinem Befehl zum Klang führt durch ein Dickicht aus Mathematik. Unter der Oberfläche arbeiten keine Musiker, sondern Algorithmen der Audio-Diffusion. Sie beginnen mit digitalem Rauschen, einem statischen Nebel ohne Struktur. Schritt für Schritt filtert die KI dieses Chaos. Sie schält Frequenzen heraus, bis eine klare Wellenform übrig bleibt. Es ist ein Prozess der Subtraktion, der aus weißem Rauschen die Klänge einer Hi-Hat oder eines Klavier formt.

Doch Klang allein ergibt noch keine hörenswerte Melodie. Hier kommen Transformer-Architekturen ins Spiel. Sie fungieren als das Gedächtnis der Maschine. Musik existiert in der Zeit; sie braucht Wiederholung, Spannung und Auflösung.

Die KI hat Milliarden von Audiosekunden analysiert. Sie liest keine Noten, sie erkennt Muster in der Anordnung von Schwingungen. Sie weiß, welche Frequenzbereiche eine menschliche Stimme definieren und wie ein Schlagzeuger den Rhythmus minimal verzögert, um Groove zu erzeugen.

Frühere Modelle scheiterten an der Langstrecke. Heutige Systeme wie Suno oder Udio halten den roten Faden über Minuten hinweg fest. Sie begreifen die Architektur eines Songs:

- Ein Refrain kehrt präzise zurück.

- Die Bridge bricht die Erwartung.

- Die Instrumentierung folgt der statistischen Wahrscheinlichkeit des Genres.

Das Ergebnis ist keine Collage, sondern eine synthetisch gewachsene Struktur. Die Maschine fühlt keine Emotionen, aber sie beherrscht die physikalischen Parameter, die diese Gefühle in uns auslösen. Mathematik übersetzt deine Intention in präzisen Schalldruck.

Suno, Udio und Co.: Die Giganten einer digitalen Musikrevolution

Jedes Werkzeug bedient eine andere Facette deines kreativen Drangs:

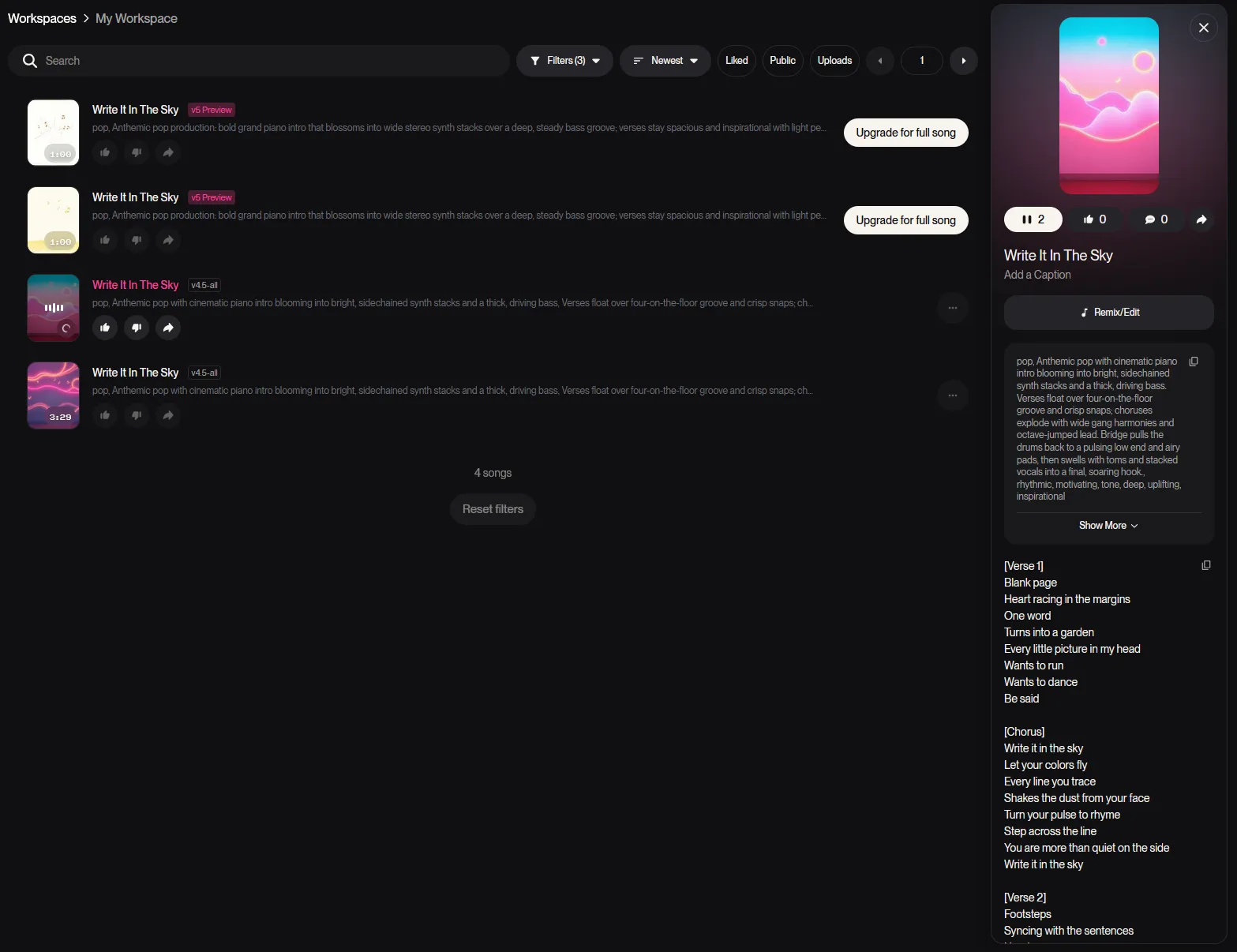

- Suno definiert momentan, wie ein KI-Song klingen muss. Das Modell beherrscht die Architektur des Pop perfekt. Es baut Spannungsbögen, setzt Refrains an die richtige Stelle und haucht digitalen Stimmen ein Timbre ein, das Hörer oft ungläubig zurücklässt.

Suno AI Player laden

Mit dem Klick auf "Song laden" akzeptierst du die Datenschutzerklärung von Suno.com. Es werden Daten an externe Server übertragen.

- Wer Udio wählt, sucht akustische Exzellenz. Diese Engine glänzt bei komplexen Harmonien und anspruchsvollen Genres. Hier wirken Instrumente weniger synthetisch, die Räumlichkeit des Klangs erinnert an professionelle Studioaufnahmen.

- Stable Audio verfolgt einen funktionaleren Ansatz. Es liefert keine fertigen Kompositionen für das Radio, sondern hochwertige Bausteine. Sound-Designer greifen hier zu, um atmosphärische Flächen oder rhythmische Schleifen zu extrahieren.

Parallel dazu wächst die Welt der Open-Source-Tools. Lokale Modelle wie AudioLDM entziehen sich der Kontrolle großer Plattformen. Du nutzt deine eigene Grafikkarte, behältst die Hoheit über deine Daten und experimentierst jenseits kommerzieller Filter.

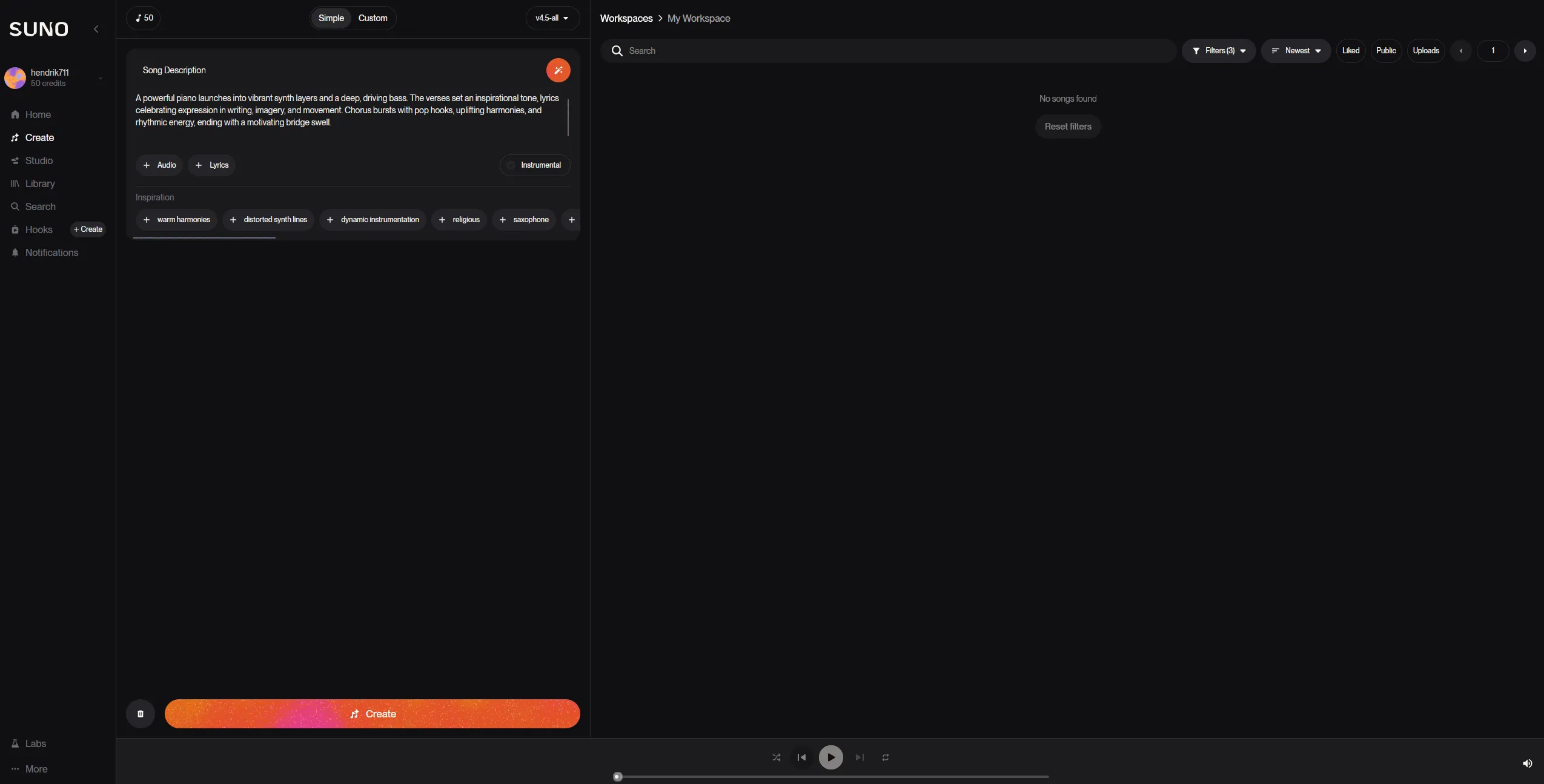

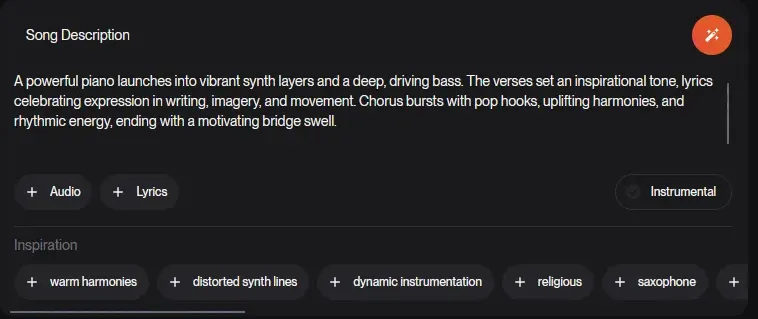

Vom Prompt zum fertigen Song: So meisterst du das Handwerk

Werkzeuge allein erzeugen keinen Rhythmus. Die Maschine wartet auf deine Anweisung, auf den präzisen Funken. Wer vage bleibt, erntet akustisches Rauschen. Wer führt, formt Klangwelten. Hier sind die drei Säulen des erfolgreichen Musik-Promptings:

1. Die DNA definieren

Nenne Genres nicht nur beim Namen, sondern verorte sie zeitlich und technisch. Ein „Dark Techno Track mit 128 BPM und analogen Synthesizern“ erzwingt eine andere Ästhetik als ein diffuser Wunsch nach Tanzmusik. Du bestimmst das Tempo, die Instrumentierung und die emotionale Temperatur.

2. Die Struktur diktieren

Die Struktur bildet das Skelett deiner Komposition. Moderne Algorithmen reagieren sensibel auf Steuerungsbefehle in eckigen Klammern. Mit Metatags wie [Intro], [Verse], [Chorus] oder [Bridge] diktierst du den dramaturgischen Verlauf. Du schreibst kein Gedicht, du entwirfst einen Bauplan. Diese Tags verhindern, dass die KI ziellos schlängelt.

Suno AI Player laden

Mit dem Klick auf "Song laden" akzeptierst du die Datenschutzerklärung von Suno.com. Es werden Daten an externe Server übertragen.

3. Iteration und Extension

Oft liefert der erste Versuch nur ein Fragment. Ein gelungener Refrain ist wertvoll, auch wenn die Strophe danach scheitert. Hier greift die Technik der Extension. Du nimmst den Kern deines Songs und lässt die KI darauf aufbauen. Du verlängerst Passagen, fügst Soli ein oder korrigierst mittels In-painting gezielt misslungene Takte. Es ist ein ständiger Dialog zwischen deiner Intention und dem Vorschlag des Algorithmus.

Deine neue Symphonie: Ein Fazit zur Zukunft der Audio-Generation

Die algorithmische Komposition markiert das Ende der handwerklichen Exklusivität. Musik wandelt sich vom starren Produkt zum fließenden Prozess. Du nutzt Suno, Udio oder lokale Open-Source-Modelle nicht als Ersatz für eigene Kreativität, sondern als massiven Katalysator. Die Barriere zwischen deiner Vision und der akustischen Realität ist fast vollständig abgetragen. Was früher Monate im Studio und horrende Budgets forderte, entsteht heute in Sekunden am Prompt.

In den kommenden zwölf Monaten werden die Grenzen weiter verschwimmen. Wir steuern auf eine Ära der totalen Multimodalität zu. Audio-Modelle werden lernen, die Dynamik von Videos in Echtzeit zu interpretieren und punktgenau zu vertonen. Die "Schrift in Bewegung" erhält so ein adaptives, klangliches Gewebe, das sich jeder Nuance anpasst. Deine Aufgabe verschiebt sich dabei endgültig: Du wirst vom ausführenden Handwerker zum strategischen Kurator.

Es geht nicht mehr darum, eine Note zu schreiben, sondern das Potenzial in einer Lawine aus Möglichkeiten zu erkennen. Die Technik liefert die Bausteine, doch die Architektur deiner Klangwelt stammt allein von dir. Nutze diese Werkzeuge, um das bisher Unhörbare zu gestalten. Dein nächster großer Song existiert bereits als statistische Wahrscheinlichkeit im Code – du musst ihn nur noch abrufen.